Поиск и блокировка вредных поисковых ботов (роботов)

Некоторые поисковые роботы создают лишнюю нагрузку на СPU сервера и не несут пользы для его индексирования. Таким ботам-паразитам необходимо ограничить вход на сайт.

Прежде чем сделать это, нужно отыскать такого бота исходя из статистики посещаемости сайта.

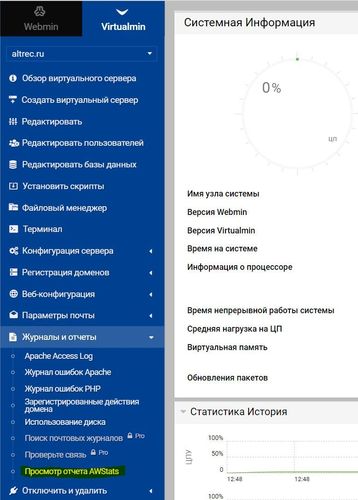

Данная статья подразумевает использование Virtualmin в качестве панели управления сервером. Думаю, в других панелях управления действия мало чем отличаются, разве только системами меню и названиями пунктов.

Определение юзер-агента ботов

На панели выбираем Журналы и отчёты → Просмотр отчёта AWStats.

Перед нами откроется окно отчёта

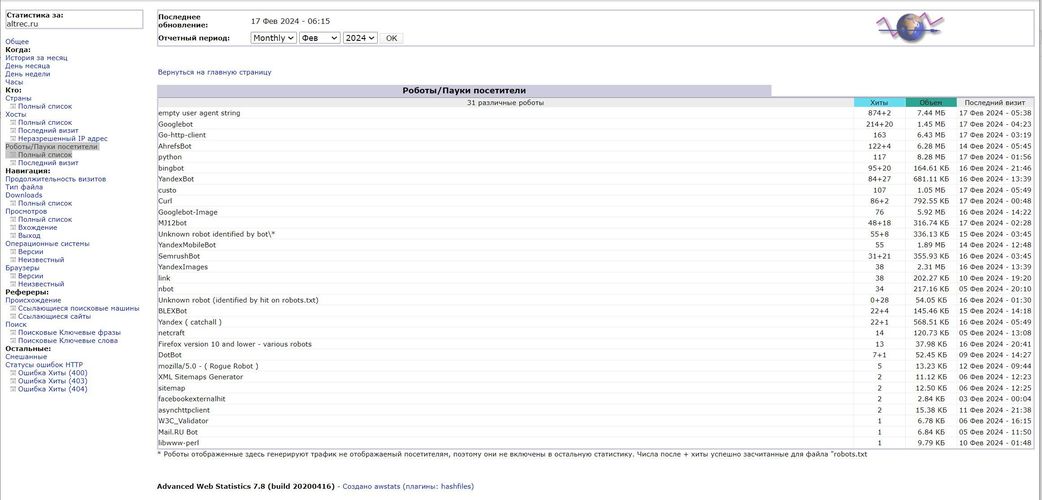

В нём выбираем Роботы/Пауки посетители → Полный список и получаем всех ботов посещающих наш сайт:

Теперь остаётся проанализировать её, выбрать имена всех ненужных роботов и забить их в файл .htaccess в корне нашего сайта.

Блокировка ботов

Открываем файл .htaccess или, если такового нет, создаём его в Notepad++ и пишем сперва запрет для безымянных ботов:

RewriteEngine on

RewriteCond %{HTTP_USER_AGENT} ^-?$

RewriteRule ^ - [F]Теперь перечисляем всех найденных ботов, которым решили запретить посещение нашего сайта:

SetEnvIfNoCase User-Agent "SemrushBot" bad_bot

SetEnvIfNoCase User-Agent "Go-http-client" bad_bot

SetEnvIfNoCase User-Agent "MJ12bot" bad_bot

SetEnvIfNoCase User-Agent "python" bad_bot

SetEnvIfNoCase User-Agent "Curl" bad_bot

SetEnvIfNoCase User-Agent "custo" bad_bot

SetEnvIfNoCase User-Agent "Firefox version 10 and lower - various robots" bad_bot

SetEnvIfNoCase User-Agent "Unknown robot (identified by hit on robots.txt) " bad_bot

SetEnvIfNoCase User-Agent "Unknown robot identified by bot\*" bad_bot

SetEnvIfNoCase User-Agent "BLEXBot" bad_bot

SetEnvIfNoCase User-Agent "AhrefsBot" bad_bot

SetEnvIfNoCase User-Agent "mozilla/5.0 - ( Rogue Robot )" bad_bot

SetEnvIfNoCase User-Agent "asynchttpclient" bad_bot

SetEnvIfNoCase User-Agent "link" bad_bot

SetEnvIfNoCase User-Agent "libwww-perl" bad_bot

SetEnvIfNoCase User-Agent "DotBot" bad_bot

SetEnvIfNoCase User-Agent "nbot" bad_bot

SetEnvIfNoCase User-Agent "netcraft" bad_bot

SetEnvIfNoCase User-Agent "facebookexternalhit" bad_bot А следующей записью запрещаем им посещение сайта:

Order Allow,Deny

Allow from all

Deny from env=bad_bot Помимо этого варианта есть и другой, в форме нашей первой записи:

RewriteEngine on

RewriteCond %{HTTP_USER_AGENT} UserAgent [NC]

RewriteRule .* - [F,L] Если ботов несколько, то не стоит на каждого делать отдельную запись, можно ограничиться одной, перечислив их в ней, а в качестве разделителя использовать |:

RewriteEngine on

RewriteCond %{HTTP_USER_AGENT} ^.*( SemrushBot| Go-http-client | MJ12bot).*$ [NC]

RewriteRule .* - [F,L] Главное помнить, что директивы Rewrite необходимо размещать в самом верху файла .htaccess.

Пример ниже позволяет блокировать список известных плохих ботов.

#Block bad bots

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} ^BlackWidow [OR]

RewriteCond %{HTTP_USER_AGENT} ^Bot\ mailto:craftbot@yahoo.com [OR]

RewriteCond %{HTTP_USER_AGENT} ^ChinaClaw [OR]

RewriteCond %{HTTP_USER_AGENT} ^Custo [OR]

RewriteCond %{HTTP_USER_AGENT} ^DISCo [OR]

RewriteCond %{HTTP_USER_AGENT} ^Download\ Demon [OR]

RewriteCond %{HTTP_USER_AGENT} ^eCatch [OR]

RewriteCond %{HTTP_USER_AGENT} ^EirGrabber [OR]

RewriteCond %{HTTP_USER_AGENT} ^EmailSiphon [OR]

RewriteCond %{HTTP_USER_AGENT} ^EmailWolf [OR]

RewriteCond %{HTTP_USER_AGENT} ^Express\ WebPictures [OR]

RewriteCond %{HTTP_USER_AGENT} ^ExtractorPro [OR]

RewriteCond %{HTTP_USER_AGENT} ^EyeNetIE [OR]

RewriteCond %{HTTP_USER_AGENT} ^FlashGet [OR]

RewriteCond %{HTTP_USER_AGENT} ^GetRight [OR]

RewriteCond %{HTTP_USER_AGENT} ^GetWeb! [OR]

RewriteCond %{HTTP_USER_AGENT} ^Go!Zilla [OR]

RewriteCond %{HTTP_USER_AGENT} ^Go-Ahead-Got-It [OR]

RewriteCond %{HTTP_USER_AGENT} ^GrabNet [OR]

RewriteCond %{HTTP_USER_AGENT} ^Grafula [OR]

RewriteCond %{HTTP_USER_AGENT} ^HMView [OR]

RewriteCond %{HTTP_USER_AGENT} HTTrack [NC,OR]

RewriteCond %{HTTP_USER_AGENT} ^Image\ Stripper [OR]

RewriteCond %{HTTP_USER_AGENT} ^Image\ Sucker [OR]

RewriteCond %{HTTP_USER_AGENT} Indy\ Library [NC,OR]

RewriteCond %{HTTP_USER_AGENT} ^InterGET [OR]

RewriteCond %{HTTP_USER_AGENT} ^Internet\ Ninja [OR]

RewriteCond %{HTTP_USER_AGENT} ^JetCar [OR]

RewriteCond %{HTTP_USER_AGENT} ^JOC\ Web\ Spider [OR]

RewriteCond %{HTTP_USER_AGENT} ^larbin [OR]

RewriteCond %{HTTP_USER_AGENT} ^LeechFTP [OR]

RewriteCond %{HTTP_USER_AGENT} ^Mass\ Downloader [OR]

RewriteCond %{HTTP_USER_AGENT} ^MIDown\ tool [OR]

RewriteCond %{HTTP_USER_AGENT} ^Mister\ PiX [OR]

RewriteCond %{HTTP_USER_AGENT} ^Navroad [OR]

RewriteCond %{HTTP_USER_AGENT} ^NearSite [OR]

RewriteCond %{HTTP_USER_AGENT} ^NetAnts [OR]

RewriteCond %{HTTP_USER_AGENT} ^NetSpider [OR]

RewriteCond %{HTTP_USER_AGENT} ^Net\ Vampire [OR]

RewriteCond %{HTTP_USER_AGENT} ^NetZIP [OR]

RewriteCond %{HTTP_USER_AGENT} ^Octopus [OR]

RewriteCond %{HTTP_USER_AGENT} ^Offline\ Explorer [OR]

RewriteCond %{HTTP_USER_AGENT} ^Offline\ Navigator [OR]

RewriteCond %{HTTP_USER_AGENT} ^PageGrabber [OR]

RewriteCond %{HTTP_USER_AGENT} ^Papa\ Foto [OR]

RewriteCond %{HTTP_USER_AGENT} ^pavuk [OR]

RewriteCond %{HTTP_USER_AGENT} ^pcBrowser [OR]

RewriteCond %{HTTP_USER_AGENT} ^RealDownload [OR]

RewriteCond %{HTTP_USER_AGENT} ^ReGet [OR]

RewriteCond %{HTTP_USER_AGENT} ^SiteSnagger [OR]

RewriteCond %{HTTP_USER_AGENT} ^SmartDownload [OR]

RewriteCond %{HTTP_USER_AGENT} ^SuperBot [OR]

RewriteCond %{HTTP_USER_AGENT} ^SuperHTTP [OR]

RewriteCond %{HTTP_USER_AGENT} ^Surfbot [OR]

RewriteCond %{HTTP_USER_AGENT} ^tAkeOut [OR]

RewriteCond %{HTTP_USER_AGENT} ^Teleport\ Pro [OR]

RewriteCond %{HTTP_USER_AGENT} ^VoidEYE [OR]

RewriteCond %{HTTP_USER_AGENT} ^Web\ Image\ Collector [OR]

RewriteCond %{HTTP_USER_AGENT} ^Web\ Sucker [OR]

RewriteCond %{HTTP_USER_AGENT} ^WebAuto [OR]

RewriteCond %{HTTP_USER_AGENT} ^WebCopier [OR]

RewriteCond %{HTTP_USER_AGENT} ^WebFetch [OR]

RewriteCond %{HTTP_USER_AGENT} ^WebGo\ IS [OR]

RewriteCond %{HTTP_USER_AGENT} ^WebLeacher [OR]

RewriteCond %{HTTP_USER_AGENT} ^WebReaper [OR]

RewriteCond %{HTTP_USER_AGENT} ^WebSauger [OR]

RewriteCond %{HTTP_USER_AGENT} ^Website\ eXtractor [OR]

RewriteCond %{HTTP_USER_AGENT} ^Website\ Quester [OR]

RewriteCond %{HTTP_USER_AGENT} ^WebStripper [OR]

RewriteCond %{HTTP_USER_AGENT} ^WebWhacker [OR]

RewriteCond %{HTTP_USER_AGENT} ^WebZIP [OR]

RewriteCond %{HTTP_USER_AGENT} ^Wget [OR]

RewriteCond %{HTTP_USER_AGENT} ^Widow [OR]

RewriteCond %{HTTP_USER_AGENT} ^WWWOFFLE [OR]

RewriteCond %{HTTP_USER_AGENT} ^Xaldon\ WebSpider [OR]

RewriteRule ^.* - [F,L]Заключение

В итоге, хотелось бы пожелать читателю поменьше ботов-паразитов и больше позитивных посетителей!